它自己觉得好,才是真的好

Written By

语嫣大厂产品经理,爱红装。

Published:

我见过无数人翻车,都是翻在这一步。 让 AI 写个科普文,它把“氧化钙”写成了“维生素”。 让 AI 算个数据,它把小数点点错了两位。

由于 AI 的语气太自信了,你根本没怀疑,直接拿去用了。 结果……社死现场。

这事儿怪谁? 怪 AI 幻觉? 不,怪你没给它配**“质检员”**。

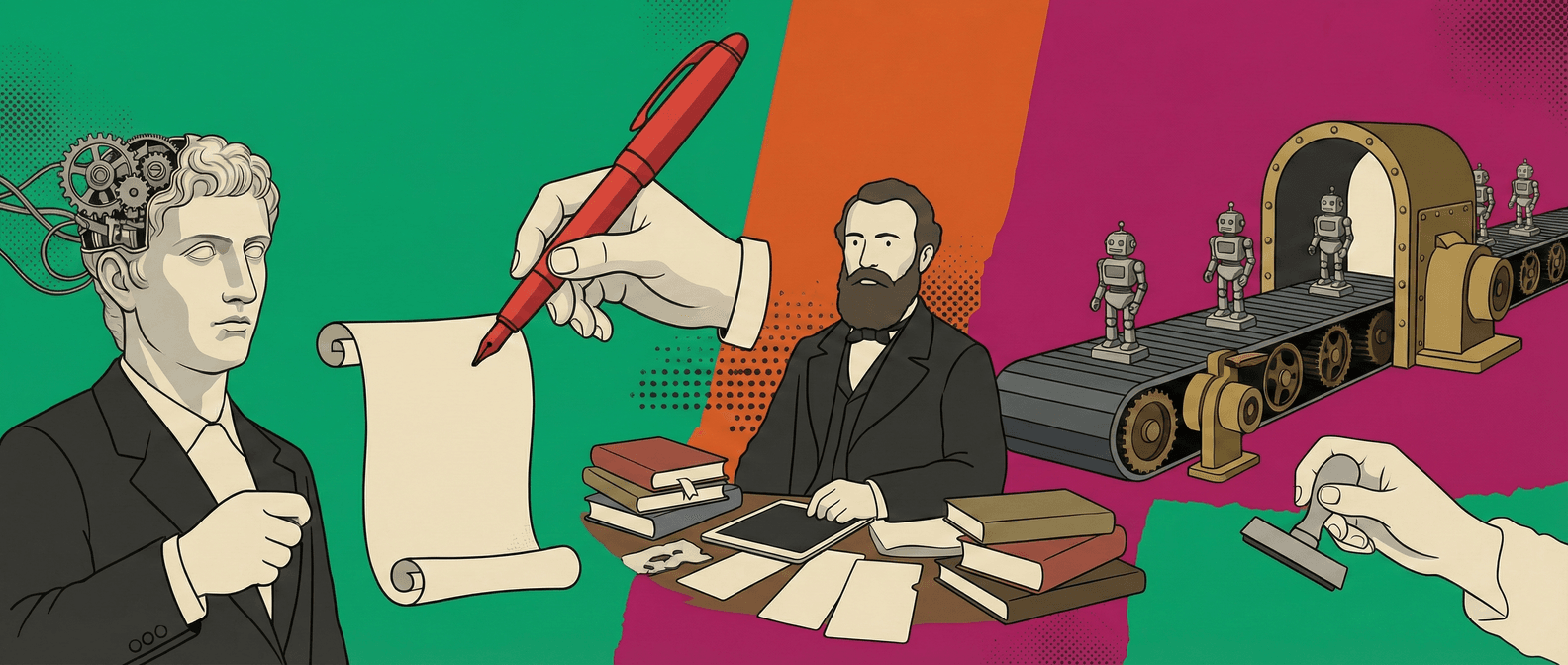

在传统的工厂流水线上,有一个铁律: 生产的人,不能兼任质检。 因为自己看自己的孩子,怎么看怎么顺眼。

AI 也是一样。 负责**Generate(生成)**的模型,为了讨好你,倾向于写出“看起来通顺”的话,而不是“正确”的话。 如果没有人管它,它就是个脱缰的野马,在“胡说八道”的大道上一路狂奔。

所以,成熟的 AI 玩家,都会引入一个新角色: Evaluator(评测员/红笔老师)。

怎么做? 很简单。在你的 Prompt 流程里,加一步:

“你现在是一个严谨的审计员。 请检查上面生成的内容。

- 所有的事实数据,是否都有来源?

- 所有的逻辑推导,是否严密? 如果发现问题,请毫不留情地指出来,并打回重写。”

你会惊讶地发现,那个刚才还信口开河的 AI,突然换了一副面孔,变得比探长还敏锐。 “经核查,第三段引用的数据是 2021 年的,且来源不详。”

这就是 Evaluation 的魔力。 它把“信任”变成了“验证”。 它给 AI 穿上了一件防弹衣。

记住,没有评测的 AI,就是在裸奔。 别等出了事再后悔。 现在,就给你的 AI 找个“红笔老师”吧。